كيفية إنشاء ملف Robots.txt متالي ل SEO موقعك (أفضل طريقة)

ملف robots.txt (يُسمى أيضًا بروتوكول أو معيار استبعاد برامج الروبوت).

يعد هذا الملف النصي الصغير جزءًا من كل موقع ويب على الإنترنت، وما لا يعرفه مشرفي المواقع ان له دور جد مهم في تحسين محركات البحث في مدة قصيرة.

لهذا السبب فإن التقنية التي سأخبرك بها اليوم هي واحدة من أفضل طرق إنشاء ملف Robots.txt.

في مسيرتي كخبير سيو تعاملت مع عدة عملاء يعانون من انخفاض ترتيب مواقعهم في محركات البحث.

عندما أخبرهم أنه يجب فقط تعديل ملف نصي صغير، فأغلبهم لا يصدق هذا الأمر.

لا تحتاج إلى أي خبرة للاستفادة من قوة ملف robots.txt. تابع القراءة حتى للاخير وكن على يقين ستتعلم أمور لم تكن تعرفها مسبقا، و سأوضح لك بالضبط كيفية إنشاء ملف Robots.txt محبب من محركات البحث.

ما هو ملف robots.txt؟

Robots.txt هو ملف نصي ينشئه مشرفو المواقع لإرشاد عناكب محرك البحث حول كيفية الزحف إلى الصفحات الموجودة على الموقع وارشفته.

يعد ملف robots.txt جزءًا من بروتوكول استبعاد برامج الروبوت (REP) ، وهو مجموعة من معايير الويب التي تنظم كيفية زحف الروبوتات إلى الويب ، والوصول إلى المحتوى وفهرسته ، وتقديم هذا المحتوى للمستخدمين. يتضمن REP أيضًا توجيهات مثل الروبوتات الوصفية ، بالإضافة إلى تعليمات الصفحات أو الدليل الفرعي أو على مستوى الموقع لكيفية تعامل محركات البحث مع الروابط (مثل “Dofollow” أو “Nofollow”).

من الناحية العملية ، تشير ملفات robots.txt إلى ما إذا كان يمكن لروبوتات الزحف إلى أجزاء من موقع الويب أم لا. يتم تحديد تعليمات الزحف هذه عن طريق “عدم السماح” أو “السماح” لهده الروبوتات مستخدم معينين (أو جميعهم).

اذن بخلاصة ملف Robots.txt هو ملف يطلب من عناكب محرك البحث عدم الزحف إلى صفحات أو أقسام معينة من موقع الويب.

ما أهمية ملف Robots.txt؟

في الحقيقة لا تحتاج معظم مواقع إلى ملف robots.txt.

وذلك لأن Google يمكنها عادةً العثور على جميع الصفحات المهمة على موقعك وفهرستها. ولن يقوم تلقائيًا بفهرسة الصفحات التي ليست مهمة أو المكررة من صفحات أخرى.

ومع ذلك ، هناك 3 أسباب رئيسية في استخدام ملف robots.txt.

- حظر الصفحات الغير المهمة: في بعض الأحيان يكون لديك صفحات على موقعك لا تريد فهرستها. على سبيل المثال، عندما تكون في مرحلة بناء صفحات جديدة غير مكتملة أو صفحة تسجيل الدخول صفحة الدفع و سلة المنتجات بالنسبة لمواقع التجارة الإلكترونية.

يجب أن تكون هذه الصفحات موجودة. لكنها بدون اضافة مهمة للموقع. هذه هي الحالة التي تستخدم فيها ملف robots.txt لمنع هذه الصفحات من برامج زحف محركات البحث وبرامج الروبوت.

- زيادة ميزانية الزحف إلى أقصى حد: إذا كنت تواجه صعوبة في فهرسة جميع صفحاتك، فقد تواجه مشكلة في ميزانية الزحف. من خلال حظر الصفحات الغير المهمة باستخدام ملف robots.txt ، يمكن لبرنامج Googlebot إنفاق المزيد من ميزانية الزحف على الصفحات المهمة فقط.

- منع فهرسة الموارد: يمكن أن يعمل استخدام التوجيهات الوصفية تمامًا مثل ملف Robots.txt لمنع فهرسة الصفحات. ومع ذلك ، لا تعمل التوجيهات الوصفية بشكل جيد للموارد ، مثل ملفات PDF والصور tag. هنا يأتي دور robots.txt.

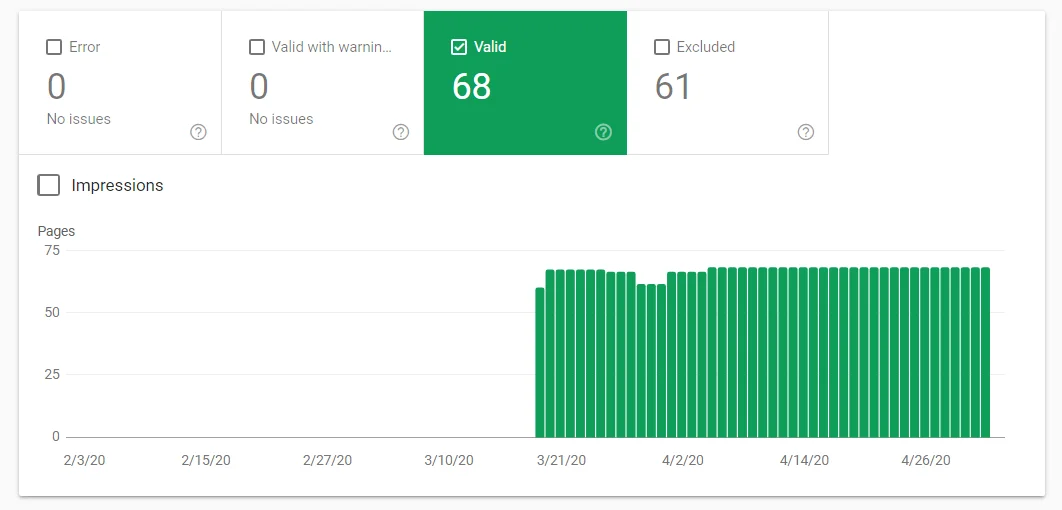

يمكنك التحقق من عدد الصفحات التي قمت بفهرستها في Google Search Console.

إذا كان الرقم يتطابق مع عدد الصفحات التي تريد فهرستها ، فلا داعي للقلق بشأن ملف Robots.txt.

ولكن إذا كان هذا الرقم أعلى مما توقعت (ولاحظت عناوين URL مفهرسة لا يجب فهرستها) ، فقد حان الوقت ل إنشاء ملف robots.txt لموقعك على الويب.

البحث عن ملف robots.txt الخاص بك

إذا كنت تريد فقط إلقاء نظرة سريعة على ملف robots.txt الخاص بك ، فهناك طريقة سهلة للغاية لعرضه.

في الواقع ، ستعمل هذه الطريقة مع أي موقع. لذا يمكنك إلقاء نظرة خاطفة على ملفات المواقع الأخرى ومعرفة ما يفعلونه.

كل ما عليك فعله هو كتابة عنوان URL الأساسي للموقع في شريط البحث في متصفحك (على سبيل المثال ، seovalide.com ، quicksprout.com ، إلخ). ثم أضف ملف robots.txt إلى النهاية.

الق نظرة على ملف Robots.txt الخاص بنا. https://seovalide.com/robots.txt

كيفية إنشاء ملف Robots.txt

إذا قمت بإنشاء صفحة robots.txt صحيحة ، يمكنك إخبار روبوتات محرك البحث (وخاصة Googlebot) لتجنب صفحات معينة.

فكر في الآثار المترتبة. إذا طلبت من روبوتات محرك البحث أن تقوم فقط بالزحف إلى المحتوى الأكثر فائدة ، فسوف تقوم برامج الروبوت بالزحف إلى موقعك وفهرسته بناءً على هذا المحتوى فقط.

كما قال جوجل:

“You don’t want your server to be overwhelmed by Google’s crawler or to waste crawl budget crawling unimportant or similar pages on your site.”

باستخدام ملف robots.txt بالطريقة الصحيحة ، يمكنك إخبار روبوتات محرك البحث بإنفاق ميزانيات الزحف الخاصة بهم بحكمة. وهذا ما يجعل ملف robots.txt مفيدًا جدًا في سياق تحسين محركات البحث.

كونه ملفًا نصيًا ، يمكنك في الواقع إنشاء ملف باستخدام notepad. وبغض النظر عن كيفية إنشاء ملف robots.txt في النهاية ، فإن التنسيق هو نفسه تمامًا:

User-agent: X

Allow: Z

Disallow: Y

وكيل المستخدم user agent هو برنامج الروبوت المحدد الذي تتحدث إليه. وكل ما يأتي بعد عدم السماح “Disallow” عبارة عن صفحات أو أقسام تريد حظرها

وكل ما يأتي بعد “Allow” عبارة عن ما تريد السماح لروبوتات بالزحف إليه وفهرسته.

إليك مثال:

User-agent: googlebot

Disallow: /images

ستطلب هذه القاعدة من Googlebot عدم فهرسة مجلد الصور لموقعك على الويب. يمكنك أيضًا استخدام علامة النجمة (*) للتحدث الى جميع برامج روبوت الزحف.

إليك مثال:

User-agent : *

Disallow: /images

تخبر علامة ” * “ جميع العناكب بعدم الزحف إلى مجلد الصور.

يحتوي هذا الدليل المفيد من Google على مزيد من المعلومات حول القواعد المختلفة التي يمكنك استخدامها لحظر برامج الروبوت أو السماح لها بالزحف إلى صفحات مختلفة من موقعك.

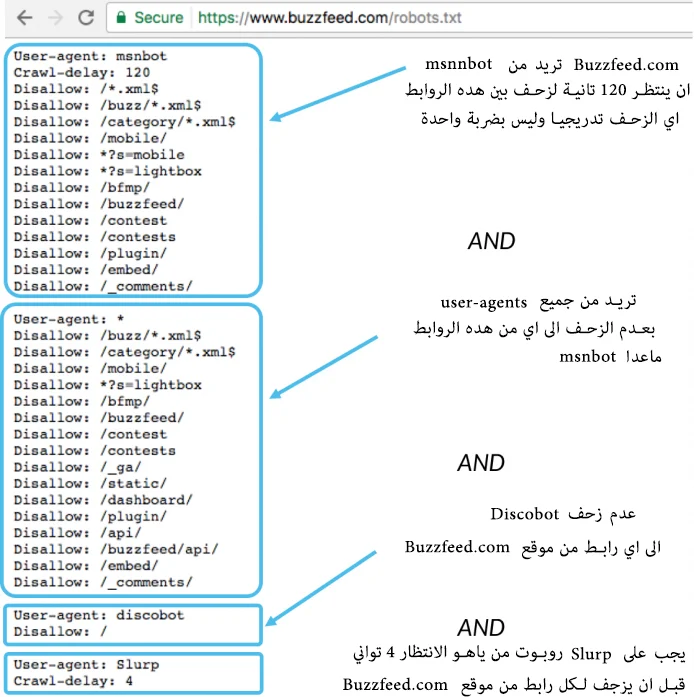

إليك بعض الأمثلة من مواقع معروفة :

يتم استدعاء كل من Msnbot و discobot و Slurp على وجه التحديد، لذا فإنهم سينتبهون فقط للتوجيهات الموجودة في أقسامهم من ملف robots.txt.

سيتبع جميع وكلاء المستخدم الآخرين التوجيهات في وكيل المستخدم.

User-agent: *

حسنا مازلت تواجه صعوبة في تحديد كيفية انشاء ملف Robots.txt خاص بك.

لقد خصصت لك واحد لكل من

فقط قم بتحميله وتابع طريقة اضافته في المرحلة الموالية.

ايضا اذا اردت اي اضافات شاهد مثال الملف الخاص بنا : https://seovalide.com/robots.txt

مصطلحات ملف robots.txt

هناك خمسة مصطلحات شائعة من المحتمل أن تصادفها في ملف robots.txt

- User-agent: الزاحف الذي تقدم له تعليمات الزحف (عادةً ما يكون محرك بحث).

يمكن العثور على قائمة بمعظم وكلاء المستخدم هنا. - Disallow: يخبر روبوت الزاحف بعدم الزحف إلى عنوان URL معين.

- allow (ينطبق فقط على Googlebot)يخبره أنه يمكن الوصول إلى صفحة أو مجلد فرعي على الرغم من أنه غير مسموح به زواحف أخرى.

- Crawl-delay: عدد الثواني التي يجب أن ينتظرها الزاحف قبل تحميل محتوى الصفحة والزحف إليه.

Googlebot لا يقر بهذا الأمر ، ولكن يمكن تعيين معدل الزحف في Google Search Console. - Sitemap: تُستخدم لاستدعاء ملفات Sitemap بتنسيق XML..

هذا الأمر مدعوم فقط من قبل Google و Ask و Bing و Yahoo.

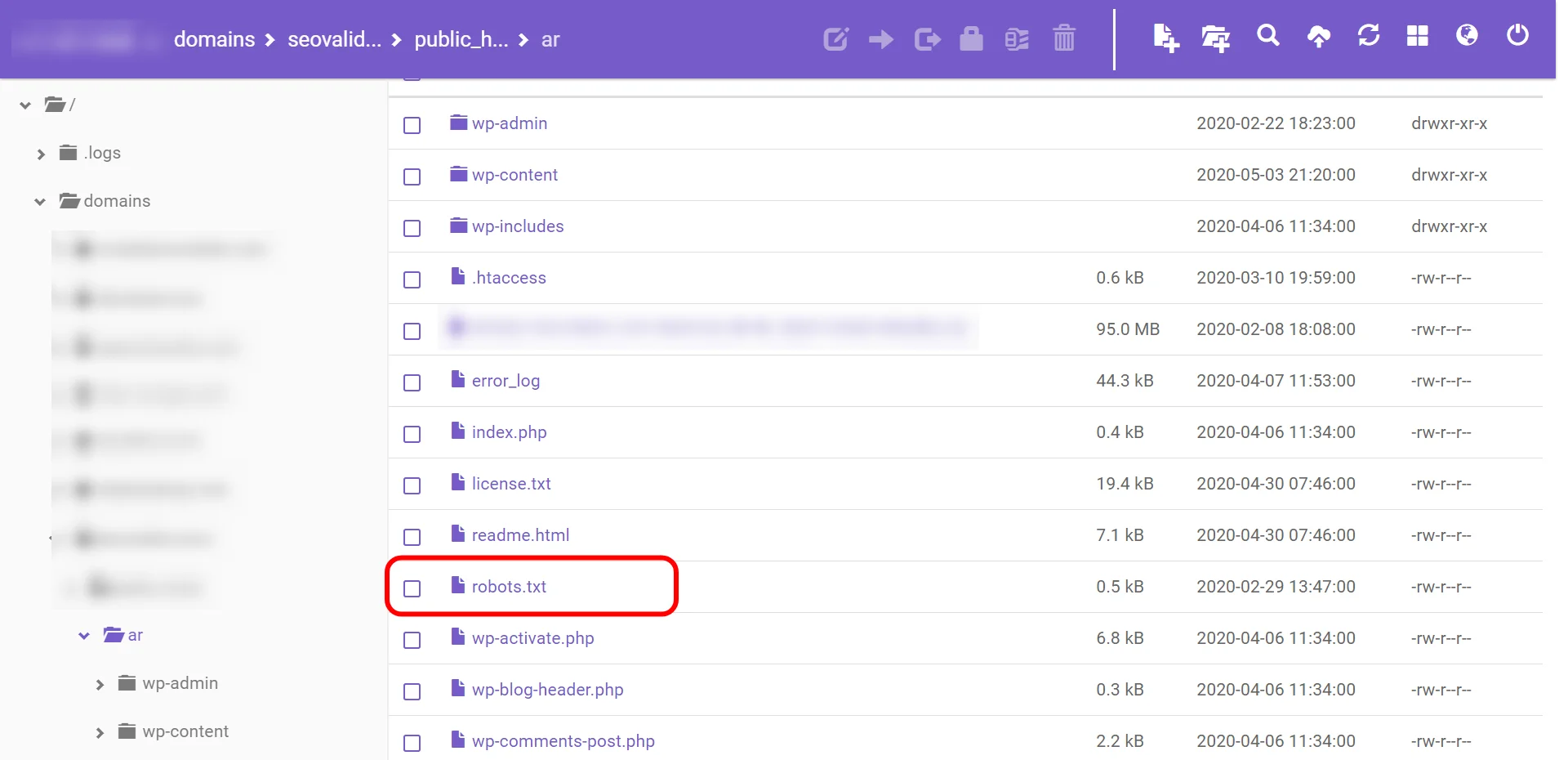

كيفية اضافة ملف Robots.txt الى موقعك وفحصه

بمجرد الحصول على ملف robots.txt الخاص بك ، فقد حان الوقت لنشره. يمكنك رفعه مباشرة لموقعك.

تأكد من وجوده عبر الرابط التالي https://example.com/robots.txt قم بتغير الاسم باسم نطاقك

(لاحظ أن ملف robots.txt حساس لحالة الأحرف. لذا تأكد من استخدام حرف “r” صغير في اسم الملف)

تحقق من الأخطاء

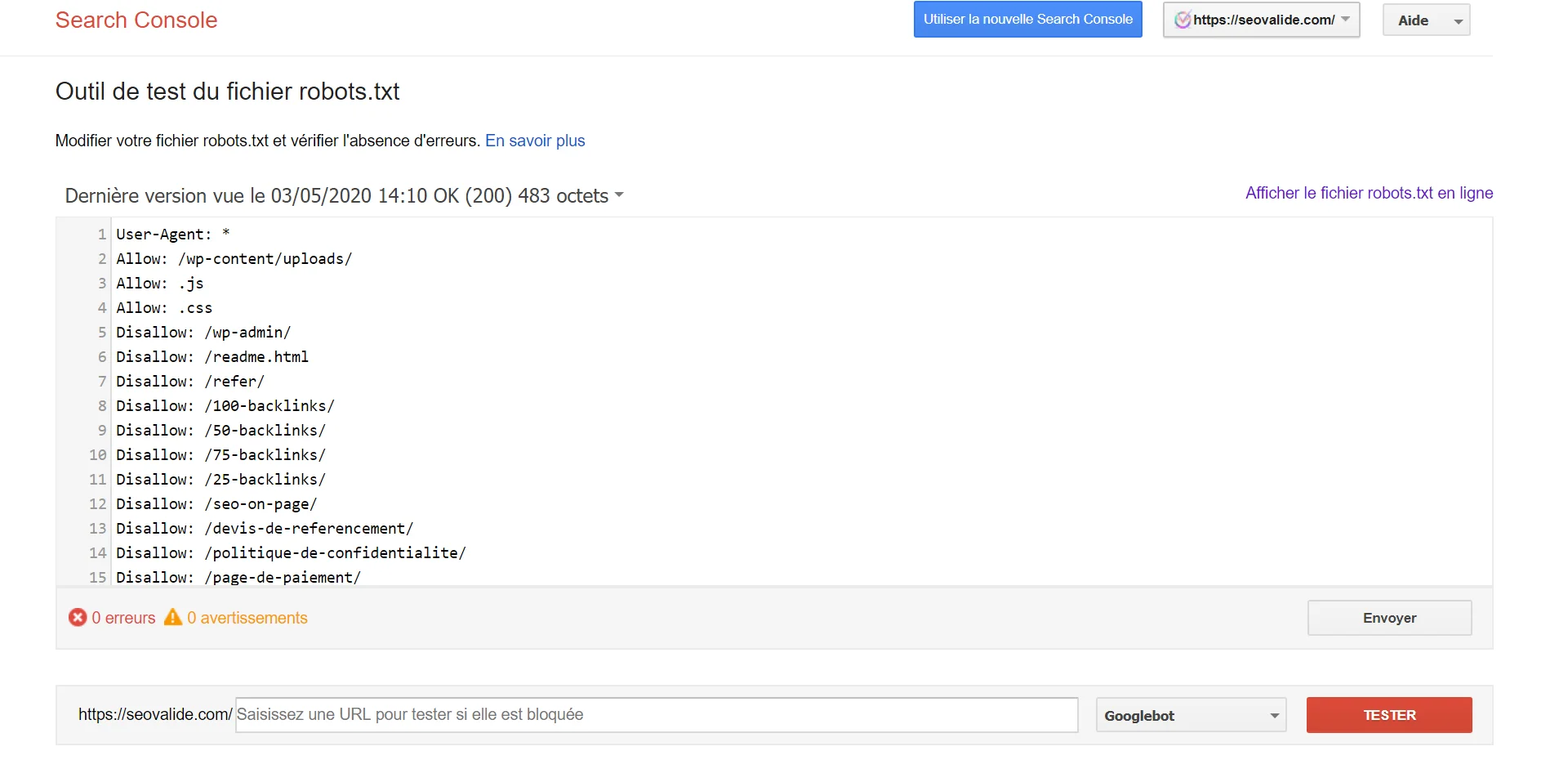

من المهم جدًا أن يتم إعداد ملف robots.txt بشكل صحيح. خطأ واحد قد يدمر موقعك. لحسن الحظ، تمتلك Google أداة اختبار روبوت رائعة يمكنك استخدامها:

يعرض لك ملف robots.txt الخاص بك … وأي أخطاء وتحذيرات يجدها كما ترون ، نحظر العناكب من الزحف إلى صفحة WP admin الخاصة بنا.

نستخدم أيضًا ملف robots.txt لمنع الزحف إلى صفحات علامات WordPress التي يتم إنشاؤها تلقائيًا (للحد من المحتوى المكرر).

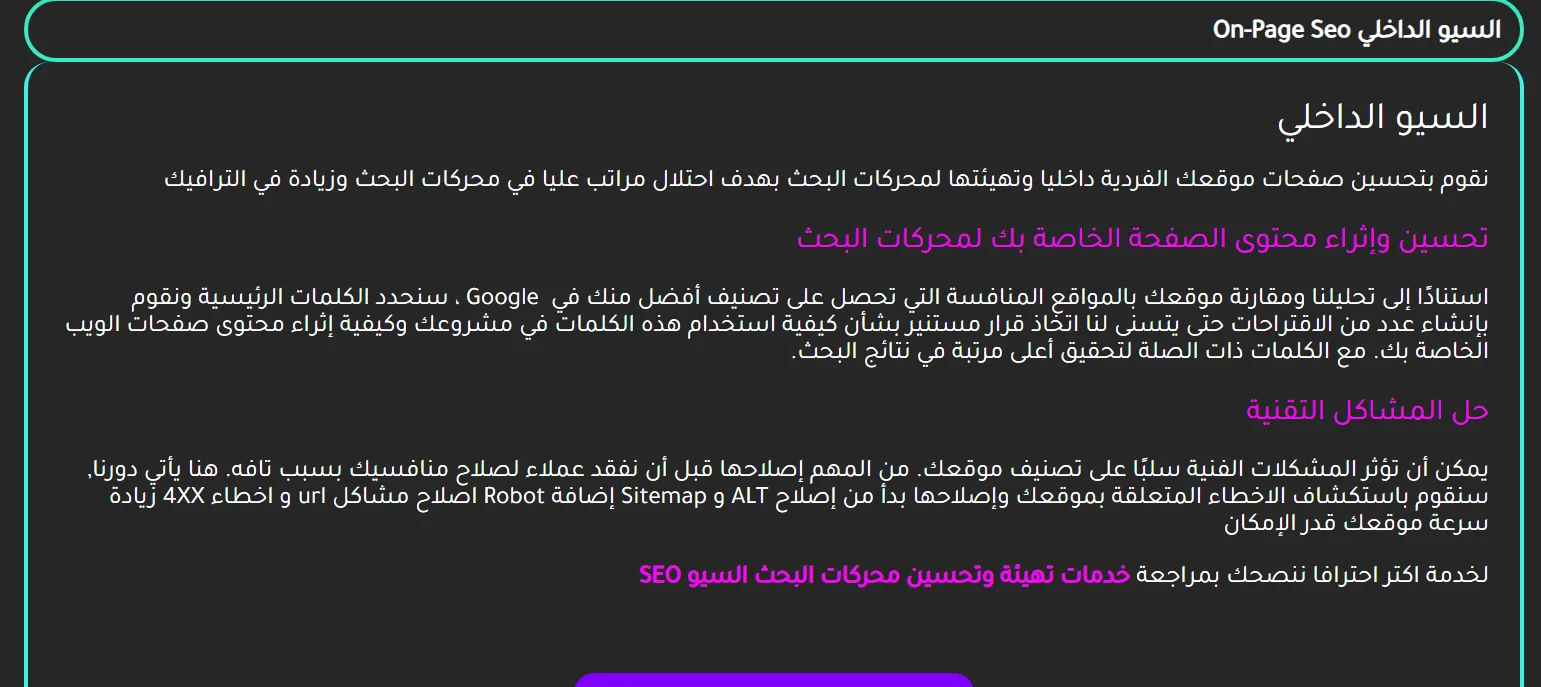

تحسين ملف robots.txt ل SEO

تعتمد كيفية تحسين ملف robots.txt على المحتوى الموجود على موقعك. هناك العديد من الطرق لاستخدام ملف robots.txt لصالحك.

سأستعرض بعض الطرق الأكثر شيوعًا لاستخدامه.

أحد أفضل استخدامات ملف robots.txt هو زيادة ميزانيات الزحف لمحركات البحث عن طريق إخبارها بعدم الزحف إلى أجزاء من موقعك التي لا تقدم قيمة مضافة.

على سبيل المثال ، إذا قمت بزيارة ملف robots.txt لموقعنا ، فسترى أنه لا يسمح بصفحة تسجيل الدخول (wp-admin). نظرًا لأن هذه الصفحة تُستخدم في الواجهة الخلفية للموقع، فلن يكون من المنطقي أن تضيع روبوتات محرك البحث وقتها في الزحف إليها.

(إذا كان لديك WordPress ، يمكنك استخدام نفس سطر عدم السماح).

يمكنك استخدام توجيه (أو أمر) مشابه لمنع برامج التتبع من الزحف إلى صفحات معينة. بعد الرفض ، أدخل جزء عنوان URL الذي يأتي بعد .com. ضع ذلك بين خطين مائلين.

لذلك إذا كنت تريد إخبار الروبوت بعدم الزحف إلى صفحتك http://yoursite.com/page/ ، يمكنك كتابة هذا:

Disallow: /page/

ما هي الصفحات التي يجب حظرها ؟

قد تتساءل على وجه التحديد عن أنواع الصفحات التي يجب استبعادها من الفهرسة. في ما يلي بعض السيناريوهات الشائعة:

محتوى مكرر هادف : على الرغم من أن المحتوى المكرر يعد أمرًا سيئًا في الغالب، ففي بعض الأحيان يعد هذا أمرا ضروري.

على سبيل المثال ، في صفحة خدمات سيو منخفضة التكلفة هنا

ستجد أن المحتوى متطابق مع هذه الصفحة هنا

ستجد أن المحتوى متطابق مع هذه الصفحة هنا

تقنيا هذا المحتوى يعتبر محتوى مكرر. في هذه الحالة ، يمكنك إخبار برامج التتبُّع بعدم الزحف إلى أحد هذه الإصدارات.

تقنيا هذا المحتوى يعتبر محتوى مكرر. في هذه الحالة ، يمكنك إخبار برامج التتبُّع بعدم الزحف إلى أحد هذه الإصدارات.

صفحة الدفع : تعتبر هده الصفحة من أهم الصفحات في مواقع التجارة الالكترونية. ولكن عزيزي فهي بدون قيمة مضافة لموقعك لذلك لا تضيع وقت الزواحف فيها

وهناك عدة صفحات يجب حظرها ولكن لا استطيع ذكرها كلها. كن ذكيا وحدد نوع صفحاتك المهمة والغير مهمة.

ملف Robots.txt مقابل تعليمات Meta

هناك أمران آخران يجب أن تعرفهما: noindex و nofollow.

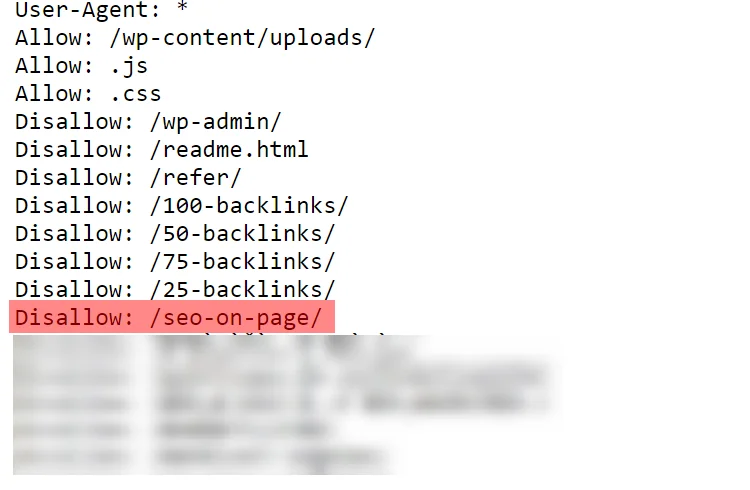

هل تعلم أن الأمر بعدم السماح الذي كنا نستخدمه؟ لا يمنع بالفعل فهرسة الصفحة.

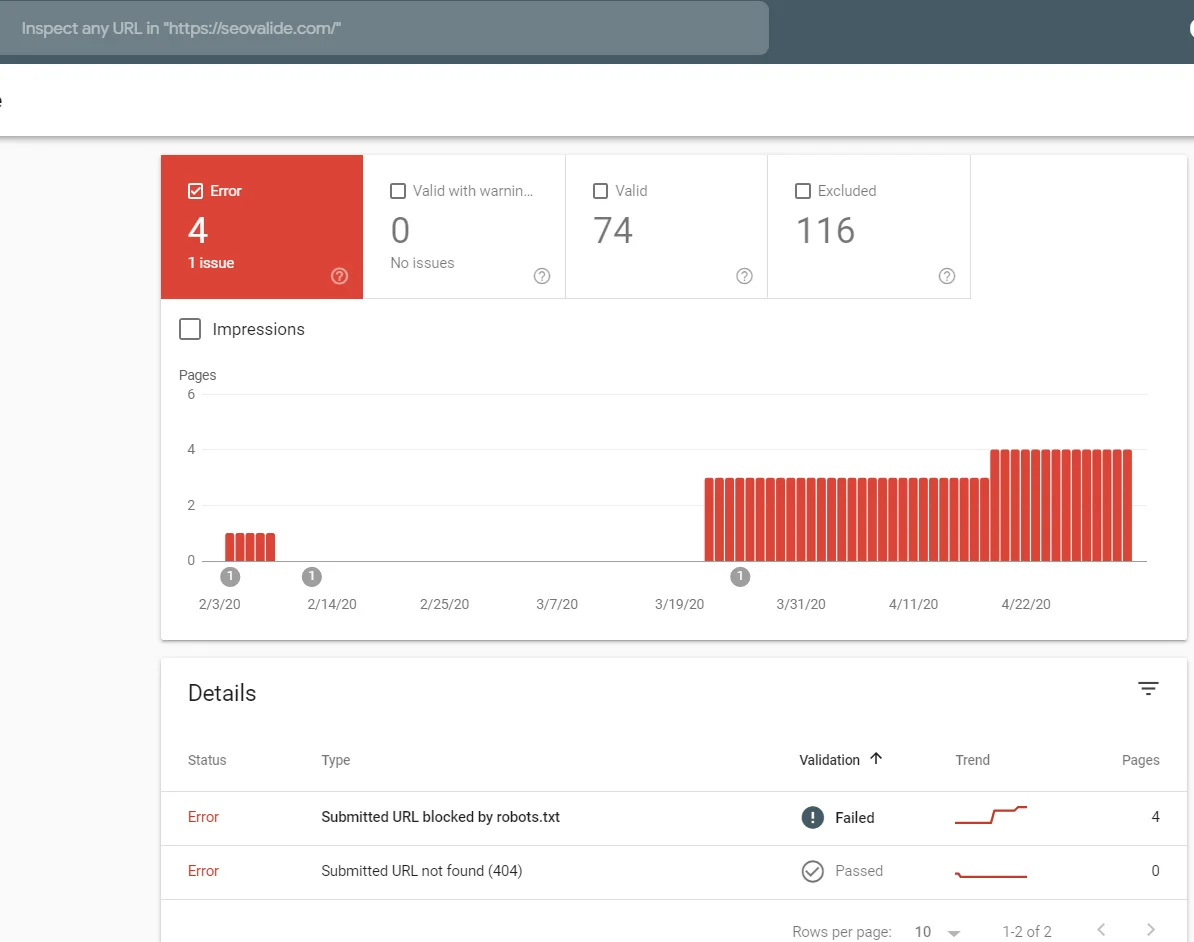

لذا من الناحية النظرية، يمكنك عدم السماح بصفحة ما، ولكن يمكن أن ينتهي بها الأمر في الفهرس. وحصول أخطاء كما هده

لهذا السبب تحتاج إلى توجيه noindex. يعمل مع أمر Disallow للتأكد من عدم قيام برامج الروبوت بزيارة صفحات معينة أو فهرستها.

إذا كانت لديك أي صفحات لا تريد فهرستها ، يمكنك استخدام كل من أمر عدم السماح وتوجيه noindex:

Disallow: /seo-on-page/

noindex: /seo-on-page/

يمكنك استخدام تعليمات Meta بأدوات سيو تغنيك عن كل هذا التعب متل yoast.

هنا قدمنا أفضل 51 أداة سيو مجانية تساعدك في تحسين محركات البحث.

الآن ، لن تظهر هذه الصفحة في SERPs.

أخيرًا ، هناك توجيه nofollow. باختصار ، يخبر روبوتات الويب بعدم الزحف إلى الروابط الموجودة على الصفحة.

ولكن سيتم تنفيذ توجيه nofollow بشكل مختلف قليلاً لأنه في الواقع ليس جزءًا من ملف robots.txt. ومع ذلك ، لا يزال توجيه nofollow يوجه روبوتات الويب ، لذا فهو نفس المفهوم. والفرق الوحيد هو مكان حدوثه.

اعثر على شفرة المصدر للصفحة التي تريد تغييرها ، وتأكد من أنك بين علامات <head>.

ثم الصق هذا الخط:

<meta name = ”robots” content = ”nofollow”>

تأكد من أنك لا تضع هذا الخط بين أي علامات أخرى —— فقط علامات <head>.

إذا كنت ترغب في إضافة كل من توجيهات noindex و nofollow ، فاستخدم سطر التعليمات البرمجية هذا:

<meta name = ”robots” content = ”noindex، nofollow”>

سيعطي هذا روبوتات الويب التوجيهين في وقت واحد.

معلومات سريعة يجب معرفتها عن ملف robots.txt

- من المفضل وضع الملف في روت الموقع الاساسي ليسهل ايجاده

- ملف Robots.txt حساس لحالة الأحرف: يجب تسمية الملف باسم “robots.txt” (وليس Robots.txt أو robots.TXT أو غير ذلك).

- قد يختار بعض وكلاء المستخدم (برامج الروبوت) تجاهل ملف robots.txt الخاص بك. هذا أمر شائع بشكل خاص مع المزيد من برامج الزحف الشائنة مثل روبوتات البرامج الضارة أو كاشطات عناوين البريد الإلكتروني.

- ملف /robots.txt متاح للجمهور: ما عليك سوى إضافة ملف /robots.txt إلى نهاية أي نطاق جذر للاطلاع على توجيهات موقع الويب هذا (إذا كان هذا الموقع يحتوي على ملف robots.txt!). وهذا يعني أن أي شخص يمكنه رؤية الصفحات التي تفعلها أو لا تريد أن يتم الزحف إليها ، لذا لا تستخدمها لإخفاء معلومات المستخدم الخاصة.

- يجب استخدام كل نطاق فرعي في نطاق جذر ملفات robots.txt منفصل.

هذا يعني أنه يجب أن يكون لكل من blog.example.com و example.com ملفات robots.txt الخاصة بهم (على blog.example.com/robots.txt و example.com/robots.txt). - من الأفضل عمومًا الإشارة إلى ملفات Sitemap المرتبطة بهذا النطاق في أسفل ملف robots.txt.

الى هنا تنهي شرح طريقة إنشاء ملف Robots.txt اتمنى ان يكون الشرح وافي وواضح

اذا اردت اي استفسار اترك تعليقا وسأكون سعيدا بالاجابة عليه